Los robots pueden desarrollar prejuicios como cualquier ser humano. Esa es la información que se desprende de un estudio del massachusetts institute of technology (MIT) en Estados Unidos. Descubrir esto no representa ningún hallazgo, pero si se sabe que estos prejuicios surgen entre grupos de robots sí lo es. El estudio se publicó en la revista Nature el pasado 6 de septiembre.

Estudios anteriores habían determinado que la Inteligencia artificial es capaz de desarrollar prejuicios. En aquellas ocasiones se descubrió que estos estaban influenciados por bases de datos generadas por humanos.

“Las simulaciones demuestran que los prejuicios son una fuerza poderosa de la naturaleza. Mediante la evolución se puede incentivar en poblaciones virtuales en detrimento de una conexión amplia con otros”. Expresó el profesor Roger Whitaker de la Universidad de Cardiff.

Prejuicios entre robots

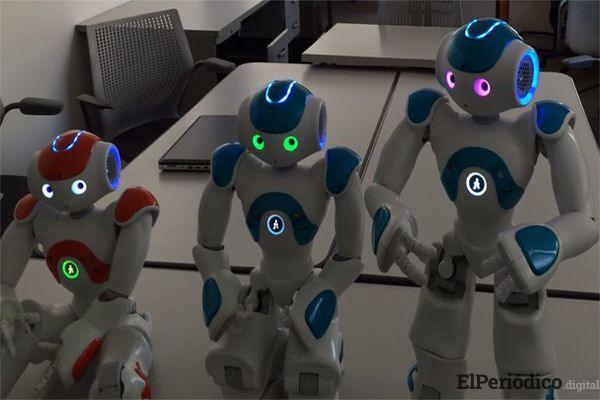

El MIT desarrolló una investigación en conjunto con la Universidad de Cardiff a partir de un simulador de trabajo en equipo. Dos grupos de robots autónomos tenían el objetivo de dar objetos a robots de su equipo o del bando contrario, siempre basándose en la reputación de cada uno y de una estrategia de donación establecida.

A través del experimento, se demostró que mientras se avanzaba a través de cientos de simulaciones; los robots aprendían nuevas estrategias copiando la información entre el mismo grupo.

Los primeros resultados arrojaron que los robots copiaron estrategias que les dejó una mayor recompensa en el corto plazo. Concluyendo que la capacidad cognitiva no era determinante en el desarrollo de los prejuicios.

A mayor población, menos prejuicios

Aunque los primeros resultados preocupan, no todo es perdido. En el mismo experimento se demostró también que los prejuicios se reducen si hay subpoblaciones en los grupos de trabajo. A mayor cantidad de unidades, se reduce la condición de minoría, no se fomentan alianzas perjudiciales y todos cooperan entre sí.

El experimento debe ser realizado en situaciones no controladas. El contexto y situación requerirá que los robots interactuen fuera de su grupo, y dependiendo de las circunstancias, medir los cambios que existan en la IA.

Estudios pasados

Que la IA puede desarrollar prejuicios como el machismo y racismo, está comprobado. Lo que no se había probado hasta ahora es que lo desarrollaran con total autonomía, hasta ahora se había probado en sistemas de IA con bases de datos y registros generados por el ser humano, mediante aprendizaje automático.

Al no ser alimentada la base de datos con suficiente cantidad de ejemplos, surgía el problema. Un ejemplo claro son los chatbots como el Tay AI de Microsoft. La IA tuvo que bloquearse luego de que a través de Twitter los usuarios le enseñaran comentarios sexistas.

“Los avances en IA involucran autonomía. Esto implica que el comportamiento de los dispositivos está determinado por los demás a su alrededor”. Resaltó Whitaker.

Esta investigación tiene gran importancia y repercusión debido al futuro que tiene. Su influencia en negocios y hogares en los próximos años será masiva y tener una IA neutra es el objetivo.